Sein Auftreten, sein gesprochenes Wort, seine leidenschaftliche Rede waren stets ein Erlebnis. Wer ihn kannte, wußte wie er sich am Redepult selbst in Schwung brachte. Wenn er bei energischem Fluß seiner fordernden Aussagen seine Jacke auszog, ohne den Mund vom Mikrophon zu nehmen, war klar, die verbale Steigerung stand kurz bevor. Der Wechsel von der Jacke zum Hemd glich einem heraufziehenden Transparent. Nun betrat die Spannung von Widerspruch und Aufhebung fast greifbar den Raum. Ihm genügte das Widersprechen nicht. Die Geste der einfachen Infragestellung des Bestehenden, die Negation, war ihm sichtlich zu wenig. Er wollte nicht nur kritisches Bewusstsein gegen etwas Vorhandenes schärfen. Er wollte zugleich ein kreatives Denken, das Neues schafft, das sich an die Stelle des Abgelehnten stellt. Sein schöpferisches Wollen war die Negation der Negation. Nicht nur gegen etwas die Stimme zu erheben, sondern sich demokratisch für gesellschaftliche Emanzipation einzusetzen, das entsprach seiner Grundhaltung.

So habe ich Oskar Negt vor Jahrzehnten persönlich kennengelernt und mehrfach mit ihm zusammengearbeitet. Sein wissenschaftliches und politisches Werk ist geprägt von der produktiven Auseinandersetzung mit der „Kritischen Theorie“ der „Frankfurter Schule“ und mit der Philosophie Ernst Blochs. Negt griff auch die Impulse der Protestbewegungen der späten sechziger Jahre auf und arbeitete sie in neue Konzepte des Lernens und des gesellschaftlichen Handelns ein. Denkerisch ging er der damaligen „Außerparlamentarischen Opposition“ von 1967/68 sogar schon voraus. So schrieb er über eines seiner eigenen Schlüsselwerke: „,Soziologische Phantasie und exemplarisches Lernen‘ ist vor jener Zeit entstanden, in der nach jahrzehntelanger Stagnation zum ersten Mal produktive Ansätze für die grundlegende Veränderung des Bildungssystems, vor allem von den Protestbewegungen entwickelt wurden, und trägt alle Züge eines Programms, das nach neuen Orientierungen in einer politischen Umbruchphase sucht.“

Oskar Negt war prominenter Soziologe, eigenständiger Sozialphilosoph und kritischer Freund der Gewerkschaften. Seine gesellschaftsanalytischen Ansätze konzentrierten sich auf das Verstehen des Faktors Arbeit und dessen Wandel sowie dessen notwendiger Gestaltung. Er akzentuierte insbesondere neue Wege des offenen, problemorientierten Lernens sowie der Erforschung des eminent wichtigen Feldes der Erfahrung und des Erfahrungswissens. Der „Negtsche Erfahrungsansatz“, wie er schlagwortartig kommuniziert wurde, stand maßgeblich Pate für die Gründung des Personennetzwerkes „Forum Soziale Technikgestaltung“ im Oktober 1991. Die Idee, ein horizontales Erfahrungsnetzwerk mit Gestaltungsabsicht ergänzend zu einem faktisch vertikalen Gewerkschaftsaufbau ins Leben zu rufen, wäre ohne Oskar Negts Grundlegungen nicht konzipierbar gewesen.

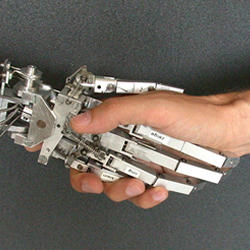

Wie aktuell sich Oskar Negts Impulse gerade heute in der angeblich ganz neuen Debatte über die „Künstliche Intelligenz“ zeigen, offenbart ein Blick zurück. Es war eine der Großveranstaltungen zum Thema Technikgestaltung, die ich planen und vorbereiten durfte. Auf Einladung der Parteien SPD, FDP und Grüne sowie von Gewerkschaften kam es zu einem bemerkenswerten Rededuell. Der einst führende Kopf des Max-Planck-Institutes für Biologische Kybernetik Tübingen (heute Cyber Valley), Prof. Valentin Braitenberg, ergriff im Plenarsaal des Landtages das Wort, um die Potenziale der „Künstlichen Intelligenz“ darzulegen. Braitenberg hatte zuvor erläutert, dass sein Motiv für diese Forschungen gerade auch in der Würdigung jener Menschen liege, die sich während des Zweiten Weltkrieges gegen den Nationalsozialismus und gegen Antisemitismus engagierten. Als kritische Technik-Gegenrede zu Braitenberg trat Prof. Oskar Negt von der Universität Hannover an. Es war ein Rededuell mit ungewöhnlich intensivem, wechselseitigem, persönlichem Respekt. Zugleich wurden die fachlichen Differenzen deutlich. Auf der einen Seite die entwickelten Methoden der mathematischen Messungen und Vermessungen des Formellen, auf der anderen Seite das Hervorheben der Erfahrung und des erfahrenden, informellen Lernens, das sich nicht mathematisieren lässt. Eine interdisziplinäre Kontroverse auf hohem qualitativen Niveau und zugleich andauernden Differenzen. Am Ende hatten beide ihre Jacken ausgezogen. Aus heutiger Perspektive, die von manchem wenig kundigem Chat-GPT-Anhänger gerne als „völlig neu“ skizziert wird, ist der Verweis auf die Jahreszahl relevant: Das aufklärende Rededuell fand im Jahr 1988 statt. Vor 36 Jahren.

Oskar Negts Erfahrungsansatz wurde Bestandteil von mehr als dreißig Jahren Tätigkeit des „Forum Soziale Technikgestaltung“ (FST). Gerade in der jüngsten Zeit hat das FST mit seinem Vorhaben „Der mitbestimmte Algorithmus“ unterstrichen, dass für eine erfolgreiche soziale Gestaltung algorithmischer Steuerungs- und Entscheidungssysteme (die sogenannte „Künstliche Intelligenz“) die Aufwertung des Erfahrungswissens unabdingbar ist. Aus FST-Sicht muss das Erfahrungswissen (Arbeitsprozesswissen) der Kolleginnen und Kollegen auf dieselbe Augenhöhe gestellt werden wie das Fach- und Sachwissen der IT-Teams. Zu diesem Zweck wurde im FST das Format „Moderierter Spezifikationsdialog“ entworfen. Dieser Dialog bildet den Ort und den Zeitpunkt für die Gestaltung dieser Technologien vor(!) der Beschaffung und vor(!) deren Einführung (Implementierung). Ein Modell, das von klugen IT-Teams aus Eigeninteresse außerordentlich begrüßt wird.

Ende der neunziger Jahre sandte uns Oskar Negt zur Veröffentlichung im Diskurs „Arbeitswelt trifft Philosophie – Philosophie trifft Arbeitswelt“ einen Beitrag mit dem Titel „Für eine Ökonomie des ganzen Hauses“. Dieser Text aus dem Jahr 1998, der den Begriff „Zeit“ ins Zentrum rückt und mit dem er an die gewerkschaftliche Veranstaltungsreihe „Zeitakademie“ in Stuttgart anschließt, endet mit einer positiven Perspektive: „Nur wenn die von drückender Erwerbsarbeit freigesetzte Lebenszeit einen eigenen, autonomen Gestaltungsraum findet, also wesentlich Emanzipations- und Orientierungszeit ist, werden die Menschen das bestimmte Gefühl haben können, nicht bloßer Verwertungsrohstoff auf anderen Feldern zu sein. Das setzte voraus, daß Kreativität, Eigeninitiative, Unbotmäßikeit und Mußefähigkeit von Kindesbeinen an maßgebende Werte der Erziehung, des Bildens und des Lernens sind. Davon sind wir weit entfernt. Aber viele Schritte führen in die Richtung einer solchen Gesellschaftsreform, die nach meiner Einschätzung einzig und allein aus der gegenwärtigen Kulturkrise Auswege zeigen könnte.“

Oskar Negt wird uns allen fehlen.

(Ein persönlicher Beitrag von Welf Schröter, 11. Februar 2024)