Der Mensch im Mittelpunkt: IST DIE „KÜNSTLICHE INTELLIGENZ“ DIE INTELLIGENZ DER ZUKUNFT? Dreißig Jahre „Forum Soziale Technikgestaltung“ (1991–2021)

Eine gemeinsame Veranstaltung des Fritz-Erler-Forums / Friedrich-Ebert-Stiftung Baden-Württemberg, der Evangelischen Kirchengemeinde Rottweil und des „Forum Soziale Technikgestaltung“ beim DGB Baden-Württemberg – unterstützt vom Netzwerk „Sozialer Zusammenhalt in digitaler Lebenswelt“ – Eine Tagung anlässlich „Dreißig Jahre Forum Soziale Technikgestaltung“.

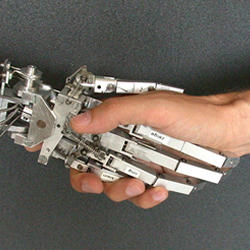

Heilsbringerin oder das Ende der denkenden Menschheit?

„Künstliche Intelligenz“ ist derzeit aus den Digitalisierungsdebatten nicht wegzudenken. Von Mobilität bis Verwaltung, von Smartphone bis Rechenzentrum – die Einsatzgebiete sind mannigfaltig. Aber wovon sprechen wir überhaupt, wenn wir über „Künstliche Intelligenz“ reden? Reden wir wirklich von Intelligenz, ebenbürtig dem geistigen Leis- tungsvermögen des Menschen? Oder sprechen wir eher von

„selbstlernenden“ Computersystemen? Und was leitet sich aus dieser Debatte für unser Verständnis vom menschlichen Denken und Lernen ab? Was sagt das über unser Menschenbild aus? Um sich im Alltag in diesem komplexen Gebiet zu orientieren und sich eine Meinung bilden zu können, muss man weder Programmiererin noch Technik-Nerd sein. Und auf keinen Fall sollte man die Gestaltung der digitalen Zukunft ausschließlich den Technologieexpert_innen überlassen. Digitalisierung ist längst im Alltag angekommen, deshalb muss sie auch von allen gestaltet werden können.

Deshalb möchten wir uns von kompetenten Gesprächspartner_innen informieren lassen, uns im Austausch mit uns und ihnen orientieren und uns so eine kritische Meinung bilden. Wir freuen uns auf Sie!

Freitag 29. Oktober 2021

14:30 ANKOMMEN BEI KAFFEE UND KUCHEN

15:00 BEGRÜSSUNG mit Esther Kuhn-Luz, Evangelische Kirchengemeinde Rottweil, Welf Schröter, Forum Soziale Technikgestaltung, Anja Dargatz, Fritz-Erler-Forum

15:15 WER DENKT, WER LENKT? MÖGLCHE ZUKÜNFTE DER AUTONOMIE UND KONTROLLE VON KÜNSTLICHER INTELLIGENZ

Impuls von Dr. Simone Kimpeler & Dipl. Ing. Lorenz Erdmann, Competence Center Foresight am Fraunhofer-Institut für System- und Innovationsforschung (ISI)

15:45 FRAGEN UND DISKUSSION

16:15 OPTIMIERT UND DIGITALISIERT – HERAUSFORDERUNGEN FÜR DAS BILD VOM MENSCHEN

Impuls von Gerhard Maag, Referent im Evangelischen Bildungszentrum Württemberg

16:45 DISKUSSION MIT DEM NEBEN-MENSCH: Was fand ich interessant? Was habe ich nicht verstanden und was möchte ich nachfragen?

17:00 PLENUMSDISKUSSION

18:00 GEMEINSAMES ABENDESSEN

19:00 PHILOSOPHIE TRIFFT ALLTAG Prof. Dr. Klaus Kornwachs, Physiker und Technikphilosoph, im Gespräch mit Anja Dargatz und Esther Kuhn-Luz

MUSIKALISCHE IMPULSE: ROTTWEILER SAXOPHONQUARTETT

20:30 AUSKLANG

21:30 ENDE DER VERANSTALTUNG

Samstag, 30. Oktober 2021

08:30 FREIHEIT UND VERANTWORTUNG: ANMERKUNGEN ZUM REFORMATORISCHEN MENSCHENBILD

EINE MORGENANDACHT mit Esther Kuhn-Luz, Evangelische Kirchengemeinde Rottweil

09:00 BEGRÜSSUNG UND EINFÜHRUNG IN DEN TAG

09:15 DIGITALISIERUNG, BIG DATA & „KI“ – GESCHÄFTSMODELL ODER GESTALTUNGSAUFTRAG?

Vortrag von Prof. Dr. Klaus Kornwachs, Physiker und Technikphilosoph

10:15 DISKUSSION IN ARBEITSGRUPPEN

11:30 PAUSE

11:45 WIE SCHAFFEN WIR ERMUTIGUNG? EMANZIPATION UND SUBJEKT-SEIN IN ZEITEN VON „KÜNSTLICHER INTELLIGENZ“ UND DIGITALISIERUNG

Impuls von Welf Schröter, Forum Soziale Technikgestaltung

GEMEINSAME ABSCHLUSSDEBATTE

13:00 MITTAGESSEN

14:00 ENDE DER VERANSTALTUNG

Anmeldung: https://www.fes.de/lnk/fachtag-digital-rottweil

Veranstaltungsort: Gemeindehaus Evangelische Kirchengemeinde, Johanniterstr. 30, 78268 Rottweil. EINGESCHRÄNKT BARRIEREFREI. Fußweg vom Bahnhof Rottweil, ca. 12 Minuten.

Teilnahmepauschale 30,00 Euro. Stellt der Beitrag ein Hindernis für Sie dar, wenden Sie sich bitte an die Organisator_innen. Übernachtung Im Hotel Sailer www.hotel-sailer.de (ca. 4 min Fußweg zum Gemeindehaus) haben wir ein kleines Kontingent an Zimmern reserviert – bitte buchen Sie dort direkt bis zum 12.09.2021 unter dem Stichwort Friedrich-Ebert-Stiftung. Der Preis pro Zimmer/Nacht beträgt 95,00 Euro. Im Preis enthalten ist ein reichhaltiges Frühstücksbüffet, W-LAN, Service und die gesetzliche Mehrwertsteuer. Kontakt und Organisation: Fritz-Erler-Forum: Daniela Jung email: daniela.jung@fes.de Tel.: 0711 / 24 83 94 – 42.