Ein Dialog zwischen dem „Forum Soziale Technikgestaltung“ (FST), dem Fraunhofer-Institut für Arbeitswirtschaft und Organisation IAO und Cyber Valley anlässlich „Dreißig Jahre Forum Soziale Technikgestaltung“

Workshop am 27. Oktober 2021 von 14.30 Uhr bis 18.45 Uhr in den Räumen des Fraunhofer IAO in Stuttgart-Vaihingen

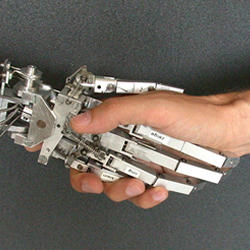

Seit langem arbeiten Wissenschaftlerinnen und Wissenschaftler an mathematisch-technischen Systemen, die die Arbeit des Menschen auf sogenannte „intelligente“ Weise effizienter gestalten und erleichtern sollen. Dabei entstehen auf der Basis von Maschinellem Lernen auch vielfältige Modelle oder Systeme, die unter dem Begriff „Künstliche Intelligenz“ zusammengefasst werden. Im Kern geht es dabei oft um die Frage, wie komplexe Analyseprozesse auf ein digitales algorithmisches System übertragen werden können und nach welchen mathematisierbaren Kriterien diese (Assistenz-)Systeme Entscheidungen treffen sollen.

Das gewerkschaftliche „Forum Soziale Technikgestaltung“ befasst sich seit dreißig Jahren mit der Humanisierung digital gestützter Arbeitswelten. Seit mehreren Jahren entwickelt das FST Kriterien zur Gestaltung algorithmischer Steuerungs- und Entscheidungssysteme. In dem Dialog-Fachworkshop soll der bisherige Stand der FST-Kriterien zur Diskussion gestellt und weiterentwickelt werden. Das FST spricht in Ergänzung zum Begriff „Assistenztechnik“ von der notwendigen Gestaltung der „Delegationstechnik“.

Das Fraunhofer-Institut für Arbeitswirtschaft und Organisation IAO entwickelt gemeinsam mit Unternehmen, Institutionen und Einrichtungen der öffentlichen Hand Strategien, Geschäftsmodelle und Lösungen für die digitale Transformation. Es ist mitverantwortlich für das KI-Fortschrittszentrum »Lernende Systeme«, das durch Technologietransfer die Lücke zwischen KI-Spitzenforschung und der breiten Anwendung in der produzierenden Industrie schließt.

Cyber Valley ist Europas größtes Forschungskonsortium im Bereich der künstlichen Intelligenz mit Partnern aus Wissenschaft und Industrie. Das Land Baden-Württemberg, die Max-Planck-Gesellschaft mit dem Max-Planck-Institut für Intelligente Systeme, die Universitäten Stuttgart und Tübingen sind u.a. die Gründungspartner dieser Initiative. Das Fraunhofer-Institut für Arbeitswirtschaft und Organisation IAO ist assoziiert mit Cyber Valley.

Ablauf

14.30 Uhr Begrüßung und Einführung

Ziele des Dialog-Workshops

Welf Schröter, Leiter des Forum Soziale Technikgestaltung beim DGB Baden-Württemberg

Dr. Matthias Tröndle, Cyber Valley, General Manager

14.45 Uhr Vortrag I

Ethische Anforderungen an die Gestaltung von KI-Technologien

PD Dr. Jessica Heesen, Forschungsschwerpunkt Medienethik und Informationstechnik (Leitung), Internationales Zentrum für Ethik in den Wissenschaften, Universität Tübingen

15.15 Uhr Rückfragen

15.30 Uhr Vortrag II

Soziale Kriterien für die Gestaltung algorithmischer Steuerungs- und Entscheidungssysteme zwischen Assistenz- und Delegationstechnik

Welf Schröter, Leiter des „Forum Soziale Technikgestaltung“, Mitbegründer der „Allianz Industrie 4.0 Baden-Württemberg“

16.00 Uhr Rückfragen

16.15 Uhr Kaffeepause

16.40 Uhr Vortrag III

Anforderungen an die Entwicklung von KI-Systemen

Dr. Matthias Peissner, Leiter Forschungsbereich Mensch-Technik-Interaktion, Fraunhofer IAO, Partner im Cyber Valley

17.10 Uhr Nachfragen

17.25 Uhr Vortrag IV

Die Gestaltung von KI-Systemen aus betriebsrätlicher Perspektive

Monika Heim, Festo SE & Co. KG, Betriebsrat Esslingen

17.55 Rückfragen

18.10 Uhr Moderierte Plenumsdiskussion der Vortragenden und Teilnehmenden

Moderation: Patrick Klügel, Cyber Valley, Public Engagement Manager

18.45 Uhr Ende der Veranstaltung

Eintritt frei. Anmeldung erforderlich bei: Welf Schröter schroeter@talheimer.de