Wer sich durch die aktuellen IT-Messen, Robotik-Ausstellungen, durch CeBITs und Hannover Messen bewegt, stößt auf sie. Wer sich mit den bunten Werbebroschüren einschlägiger Interessenverbände beschäftigt, kommt um das Schlagwort kaum herum. Wer sich im Netz auf Youtube mit dem vermeintlichen „Industrie 4.0“ auseinandersetzt, konfrontiert sich mit dem Begriff „Autonome Systeme“. In einem großen Schlagwort-Püree werden Digitalisierung, Virtualisierung, Künstliche Intelligenz (KI), Industrie 4.0, Arbeit 4.0, Robotik, Big Data, selbstfahrende Autos zu einem großen Gemisch zusammengerührt, das weder ermutigt, noch aufklärt, eher verklärt und eher irritiert. Der Satz „Alles hängt mit allem zusammen“ ist seit der Genesis (christliche Schöpfungserklärung) richtig und bringt daher keine weitere Erkenntnis.

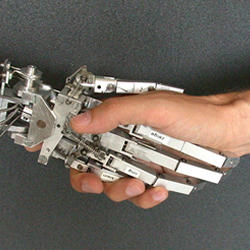

Für viele Kolleginnen und Kollegen in den Betrieben, die das obige Gemisch aus der Perspektive der Arbeitswelt zu entwirren suchen, verbindet sich die Bezeichnung „Autonome Systeme“ mit Bildern von selbstlaufenden aufrechten Robotern, mit fahrerlosen Fahrzeugen oder mit selbstfahrenden Transportsystemen zur Anlieferung von Montagebauteilen. Kein Wunder: Wir sind es gewohnt, zunächst an Gegenständliches, an Physisch-Materielles zu denken. Wir sehen Hardware. Wir wollen anfassen.

Doch genau hier liegt eine der schwierigsten Herausforderungen im Wandel der Arbeitswelt. Die strategische Bedeutung der Bezeichnung „Autonome Systeme“ liegt nicht zuallererst in dem, was wir sehen und greifen können, sondern in dem, was nicht-materiell und im umgangssprachlichen Sinne „unsichtbar“ ist. Es ist die Software. Es sind insbesondere die Phänomene der „Autonomen Software-Systeme“ (ASS), der „selbstlernenden“ und „selbstentscheidenden“ Softwarelösungen, der Softwareanwendungen mit automatisierendem Vollzug in Verknüpfung mit „Cyber-Physischen Systemen“ (CPS).

Wir sind es gewohnt, vom sichtbaren mobilen oder nicht-mobilen Endgerät her zu denken, von der Displayfläche der Hardware. „Autonome Software-Systeme“ wirken aber – bildlich gesprochen – „hinter dem Bildschirm“, hinter dem Display. Statt uns auf das „Front-End“ zu konzentrieren, müssen wir uns besser im Gelände des „Back-End“ umsehen und dieses offensiv gestalten. Die Zukunft der Arbeit wird im „Back-End“ entschieden nicht im „Front-End“.

Die Verbesserung der Geräte-Nutzbarkeit, die Usability, die Ergonomie und die gesunde Handhabbarkeit sind zweifellos wichtig und dürfen nicht unterschätzt werden. Aber genauso wichtig ist die immer stärker zunehmende Kraft der Software, die faktisch Arbeitsabläufe und Geschäftsprozesse zu strukturieren und zu steuern versucht.

Es muss uns um die „Demokratisierung des Back-End“ (Schröter) und um die Demokratisierung der Prinzipien und generischen Kriterien für Algorithmen gehen. Wir benötigen offene interdisziplinäre Diskurse und Gestaltungskompetenz für die Idee des generisch (in seinen Grundsätzen) „mitbestimmten Algorithmus“ (Schröter).

In diesem Sinne muss den schon in der Arbeitswelt praktisch angekommenen Phänomenen der „Autonomen Software-Systemen“ (ASS) unsere wachsende und immer größer werdende Aufmerksamkeit gelten.