Im Widerstand der Alliierten gegen die Hitler-Diktatur haben sich in den vierziger Jahren Wissenschaftlerinnen und Wissenschaftler zusammengefunden, um durch neue Wege der Informationsverarbeitung dazu beizutragen, den Nationalsozialismus zu zerschlagen. Die heutige Debatte über die sogenannte „Künstliche Intelligenz“ hat eine lange Vorgeschichte. Da sei beispielhaft an den Tübinger Biokybernetiker Prof. Dr. Valentin Braitenberg erinnert, der in den achtziger Jahren des letzten Jahrhunderts sein Engagement für „KI“ unter anderem mit dem Verweis auf die Shoah begründete.

Doch heute findet sich außerhalb des wissenschaftlichen Diskurses eine Fülle von Marketing-Versprechungen, die dazu geeignet sind, die Ideen, die hinter dem Traum der „KI“ stehen, erheblich zu beschädigen. Da verkünden große Firmen, dass demnächst das Auto besser denken könne als der Mensch. Was für ein Menschenbild steht hinter dieser Äußerung? An anderer Stelle des allgegenwärtigen Messe-Slangs werden alte Software-Hüte aus dreißig Jahren Digitalisierung als neue Produkte eines „KI“-Marktes präsentiert. Die Expertensysteme der neunziger Jahre, die Softwareagentensysteme aus der Zeit kurz nach der Jahrtausendwende und die Schlüsselanwendungen aus dem Jahr 2011 – gemeint sind die „Cyber-Physischen Systeme“ der „Industrie 4.0“ – sind plötzlich der jüngste Schrei der „KI“. Wir sollten nüchterner und ehrlicher werden. Helfen uns neue Etiketten für alte Produkte? Was gibt es schon lange? Was ist wirklich neu?

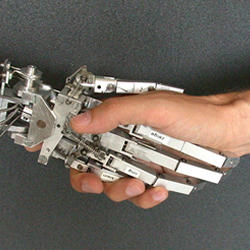

Die vermeintliche „KI“ ist auch mit den Worten „Robotik“ oder „selbstfahrende Autos“ nicht erklärt. Die mathematische Informationsverarbeitung ist Software. Das Blech der Roboter und der Autos ist nur das Anhängsel der Software. Die vernünftige Übersetzung des amerikanisch-englischen Wortes „artificial intelligence“ lautet nicht „Künstliche Intelligenz“ sondern „Künstliche Nachbildung“. Damit kommen wir dem Thema näher.

Seien wir mutig und ehrlich zugleich. Bei der Beantwortung der Frage, was tatsächlich neu ist, finden wir zu einer selbstbewussten Haltung des Respekts gegenüber verantwortungsbewussten IT-Teams zurück. Hinter dem Marketing-Hype steckt ein tatsächlicher Fortschritt: Was wir an neuen IT-technischen Leistungen vorfinden, hat aber nichts mit Software-„Intelligenz“ zu tun. Es „denkt“ nicht, „lernt“ nicht und hat kein „Ich“. Die Leistung steckt in brillanten Lösungen auf dem Gebiet der mathematischen und mathematisierenden Informationsverarbeitung. Brillante Mathematik. Von Menschen gemacht, von Menschen gestaltbar.

Das wirklich Neue liegt in mindestens zwei Perspektiven: Neben Software als starres, sich nicht veränderndes Werkzeug tritt Software als ein sich selbst veränderndes Werkzeug. Hinzu kommt die weitreichende Öffnung der Software-Entwicklung von der Qualität der „Assistenztechnik“ hin zum Potenzial der „Delegationstechnik“ (Schröter). Somit kann eine Software die Vollmacht bekommen, hinter dem Rücken des Menschen in Echtzeit rechtsverbindliche Prozesse (Transaktionen) zu analysieren, zu steuern und zu entscheiden. Das ist wirklich neu. Aber auch diese „Delegationstechnik“ „denkt“ nicht, „lernt“ nicht, hat kein „Ich“. Es bleibt Mathematik. Allerdings in exzellenter Form. Wir benötigen diese Technik unter anderem für das Erreichen der Klimaneutralität.

Sollen wir weiterhin von „KI“ reden? Es wäre ehrlicher, etwas tiefer anzusetzen. Vielleicht hilft – als provisorische Zwischenstufe für das Weiterdenken – nachfolgende Formulierung auf der Basis langjähriger Erfahrungen aus dem „Forum Soziale Technikgestaltung“ bei arbeitsweltbezogenen Technikeinführungen:

Es geht um die soziale Gestaltung „algorithmischer Steuerungs- und Entscheidungs-systeme“. Oder etwas umfänglicher ausgedrückt: Es geht um die Gestaltung „algorithmischer, sich selbst verändernder Software-Systeme für die arbeitsweltlichen Vorgänge wie Analyse, Entscheidungsvorbereitung, Prozesssteuerung und Entscheidungsvollzug im Feld der Assistenz- und Delegationstechnik“ (Schröter).